ابرکامپیوتر انویدیا می تواند عصر جدیدی از ChatGPT را آغاز کند

انویدیا به تازگی ابررایانه جدیدی را معرفی کرده است که می تواند آینده هوش مصنوعی را تغییر دهد. DGX GH200 با تقریبا 500 برابر حافظه بیشتر از سیستم هایی که اکنون با آنها آشنا هستیم، به زودی به دست گوگل، متا و مایکروسافت راه پیدا می کند.

هدف؟ انقلابی در هوش مصنوعی، سیستمهای توصیهگر و پردازش دادهها در مقیاسی که قبلاً دیده نشده بود. آیا مدل های زبانی مانند GPT مفید خواهند بود و این برای کاربران عادی چه معنایی خواهد داشت؟

توصیف DGX GH200 انویدیا مستلزم استفاده از عباراتی است که اکثر کاربران هرگز با آن مواجه نخواهند شد. به عنوان مثال، “Exaflop”، زیرا این ابررایانه 1 اگزافلاپ عملکرد و 144 ترابایت حافظه مشترک را ارائه می دهد. انویدیا خاطرنشان می کند که این به معنای تقریبا 500 برابر حافظه بیشتر از یک سیستم واحد Nvidia DGX A100 است.

بیایید به شکل 1 exaflop دایره ای برگردیم و کمی آن را تجزیه کنیم. یک اگزافلاپ برابر با یک کوئینتیلیون عملیات ممیز شناور در ثانیه (FLOP) است. در مقایسه، RTX 4090 انویدیا می تواند در صورت اورکلاک به حدود 100 ترافلاپ (TFLOPs) برسد. یک TFLOP معادل یک تریلیون عملیات ممیز شناور در ثانیه است. تفاوت خیره کننده است، اما مطمئنا RTX 4090 یک GPU مرکز داده نیست. از سوی دیگر، DGX GH200 تعداد قابل توجهی از این پردازندههای گرافیکی با کارایی بالا را که به رایانههای شخصی مصرفکننده تعلق ندارند، ادغام میکند.

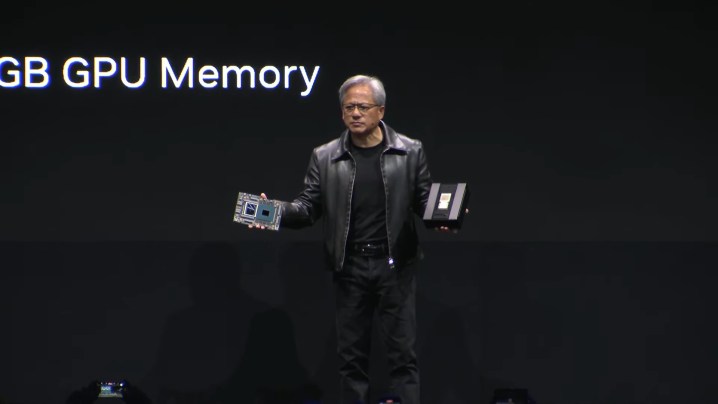

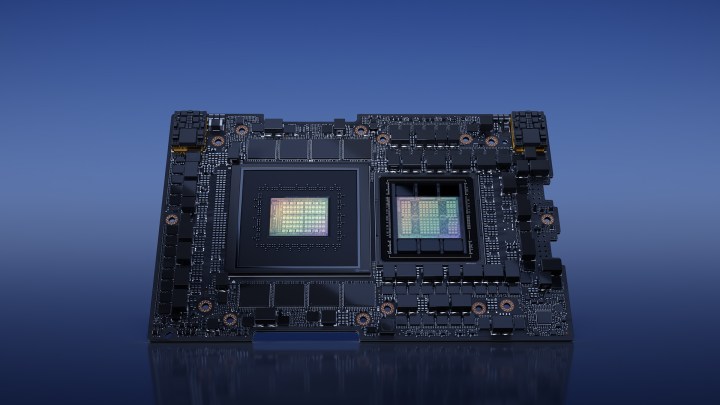

این کامپیوتر از سوپرتراشه های GH200 Grace Hopper انویدیا تامین می شود. در مجموع ۲۵۶ عدد از آنها وجود دارد که به لطف فناوری NVLink Nvidia، همگی میتوانند به عنوان یک سیستم واحد با هم کار کنند و اساساً یک GPU عظیم ایجاد کنند.

سوپرتراشههای GH200 که در اینجا استفاده میشوند نیز نیازی به اتصال PCIe سنتی بین CPU و GPU ندارند. انویدیا می گوید اکنون به پردازنده گرافیکی Nvidia Grace CP,U مبتنی بر ARM و همچنین پردازنده گرافیکی H100 Tensor Core مجهز شده است. انویدیا چندین پیوند تراشه فوق العاده در اینجا نیز دارد، این بار با استفاده از NVLink-C2C. در نتیجه، ادعا می شود که پهنای باند بین CPU و کارت گرافیک به طور قابل توجهی بهبود یافته است (تا 7 برابر) و مصرف انرژی بیشتر (تا 5 برابر).

بسته بندی بیش از 200 عدد از این تراشه ها در یک نیروگاه ابرکامپیوتر به اندازه کافی چشمگیر است، اما وقتی در نظر بگیرید که قبلا فقط هشت پردازنده گرافیکی می توانستند به طور همزمان به NVLink متصل شوند، حتی بهتر می شود. جهش از هشت تراشه به 256 تراشه مطمئناً به انویدیا حق افتخار می دهد.

تصور اینکه DGX GH200 بتواند بهبودهایی را در Bard، ChatGPT و Bing Chat ارائه دهد، سخت است.

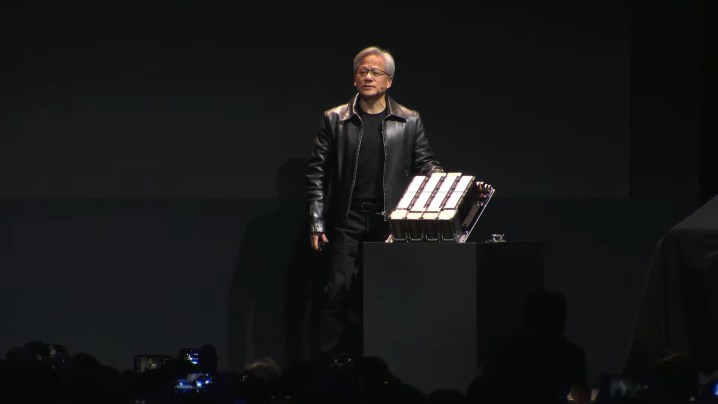

حال، DGX GH200 به کجا خواهد رفت و چه چیزی می تواند به جهان ارائه دهد؟ انویدیا در حال ساخت ابر رایانه هلیوس خود به عنوان ابزاری برای پیشرفت تحقیق و توسعه هوش مصنوعی است. این شامل چهار سیستم DGX GH200 است که همگی توسط Quantum-2 InfiniBand انویدیا متصل می شوند. انتظار می رود تا پایان سال به صورت آنلاین عرضه شود.

انویدیا نیز توسعه جدید خود را با گوگل کلود، متا و مایکروسافت آغاز کرده است. هدف تقریباً یکسان است – کاوش بارهای کاری مولد هوش مصنوعی.

وقتی صحبت از گوگل و مایکروسافت به میان میآید، تصور اینکه DGX GH200 میتواند پیشرفتهایی در Bard، ChatGPT و Bing Chat داشته باشد، سخت است.

قدرت محاسباتی قابل توجهی که توسط یک سیستم واحد DGX GH200 ارائه میشود، آن را برای پیشبرد یادگیری مدلهای زبانی پیچیده مناسب میسازد. به سختی می توان گفت دقیقاً چه معنایی می تواند بدون اظهار نظر یکی از طرف های درگیر داشته باشد، اما می توانیم کمی حدس بزنیم.

قدرت بیشتر به معنای مدلهای بزرگتر است، که به معنای متن ظریفتر و دقیقتر و مجموعه دادههای گستردهتر برای آموزش است. ما ممکن است درک فرهنگی بهتر، آگاهی زمینه ای بیشتر و همسویی بیشتر را ببینیم. چت ربات های تخصصی هوش مصنوعی نیز ممکن است شروع به ظهور کنند و بیشتر جایگزین انسان ها در زمینه هایی مانند فناوری شوند.

آیا باید نگران جابهجایی شغلی بالقوه باشیم یا باید از پیشرفتهایی که این ابررایانهها میتوانند به ارمغان بیاورند هیجان زده باشیم؟ پاسخ روشن نیست. یک چیز مطمئن است، DGX GH200 انویدیا می تواند همه چیز را در دنیای هوش مصنوعی متزلزل کند و انویدیا به تازگی برتری هوش مصنوعی خود را یک بار دیگر نسبت به AMD افزایش داده است.

توصیه های سردبیران