پردازندههای گرافیکی RTX اکنون با یک چت ربات بومی هوش مصنوعی عرضه میشوند. خوبی؟

توجیه بسته بندی سخت افزار اختصاصی هوش مصنوعی در رایانه شخصی دشوار بود. انویدیا سعی دارد با Chat with RTX که یک چت ربات محلی هوش مصنوعی است که از سختافزار GPU Nvidia شما برای اجرای یک مدل هوش مصنوعی استفاده میکند، این وضعیت را تغییر دهد.

این ابزار چندین مزیت منحصر به فرد را نسبت به چیزی مانند ChatGPT ارائه می دهد، اما این ابزار هنوز مشکلات عجیبی دارد. ویژگیهای عجیب و غریبی که با هر چت ربات هوش مصنوعی در اینجا دارید، وجود دارد، اما همچنین مشکلات بزرگتری وجود دارد که ثابت میکند چت با RTX نیاز به کار دارد.

با RTX چت کنید

در اینجا واضح ترین سوال چت RTX وجود دارد: تفاوت آن با ChatGPT چیست؟ چت با RTX یک است محلی مدل زبان بزرگ (LLM). از مدلهای سازگار با TensorRT-LLM استفاده میکند – Mistral و Llama 2 به طور پیشفرض گنجانده شدهاند – و آنها را روی دادههای محلی شما اعمال میکند. علاوه بر این، محاسبات واقعی به صورت محلی روی کارت گرافیک شما انجام می شود، نه در فضای ابری. چت RTX به پردازنده گرافیکی 30 یا 40 سری Nvidia RTX و حداقل 8 گیگابایت VRAM نیاز دارد.

یک مدل محلی چندین ویژگی منحصر به فرد را باز می کند. برای شروع، شما داده های خود را در چت با RTX بارگذاری می کنید. میتوانید پوشهای پر از اسناد جمعآوری کنید، Chat with RTX را روی آن قرار دهید و بر اساس آن دادهها با مدل تعامل کنید. این یک سطح دقیقتر از ویژگی را ارائه میکند و به مدل اجازه میدهد تا اطلاعاتی درباره اسناد دقیق ارائه کند، به جای پاسخهای کلیتری که با چیزی مانند Bing Chat یا ChatGPT میبینید.

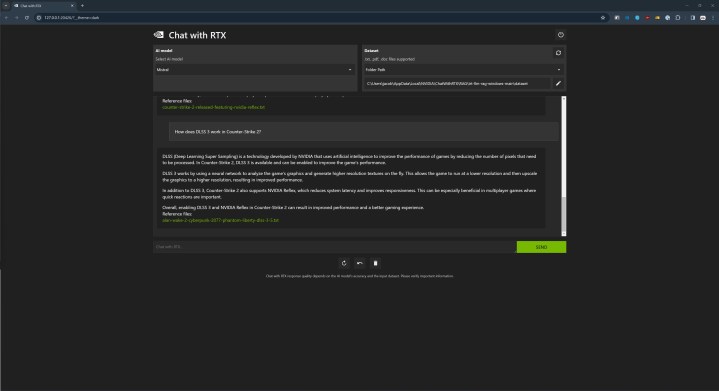

و کار می کند. من یک پوشه حاوی مجموعه ای از مقالات تحقیقاتی را بارگذاری کردم که جزئیات DLSS 3 انویدیا، FSR 2 AMD و XeSS اینتل را نشان می داد و سؤالات خاصی در مورد تفاوت آنها پرسیدم. به جای جستوجو در اینترنت و بازنویسی مقالهای که تفاوتها را توضیح میدهد – یک تاکتیک رایج برای چیزی مانند چت بینگ – چت با RTX قادر به ارائه پاسخهای دقیق بر اساس مقالات تحقیقاتی واقعی بود.

از اینکه Chat with RTX توانست اطلاعاتی را از برخی مقالات علمی استخراج کند، شوکه نشدم، اما از اینکه توانست این اطلاعات را به خوبی تقطیر کند، شوکه شدم. مقالاتی که ارائه کردم مقالات علمی پر از اظهارات آکادمیک، معادلاتی که سرتان را به هم می زند، و ارجاع به جزئیاتی بود که در خود مقاله توضیح داده نشده است. با این حال، چت با RTX اسناد را به اطلاعاتی تقسیم کرد که به راحتی قابل درک بود.

همچنین میتوانید Chat with RTX را به یک ویدیو یا فهرست پخش YouTube هدایت کنید و اطلاعات را از رونوشتها دانلود میکند. ماهیت واضح ابزار جایی است که واقعاً می درخشد، aa به شما امکان می دهد به جای پرسیدن سؤال در مورد هر چیزی مانند ChatGPT، جلسه را در یک جهت متمرکز کنید.

مزیت دیگر این است که همه چیز به صورت محلی اتفاق می افتد. شما مجبور نیستید درخواست های خود را به سرور ارسال کنید یا اسناد خود را آپلود کنید و نگران باشید که از آنها برای آموزش بیشتر مدل استفاده شود. این یک رویکرد ساده برای تعامل با یک مدل هوش مصنوعی است – شما از داده های خود در رایانه خود استفاده می کنید و بدون هیچ گونه نگرانی در مورد آنچه در طرف دیگر مدل اتفاق می افتد، سؤالات مورد نیاز خود را مطرح می کنید.

با این حال، اشکالاتی در رویکرد محلی Chat با RTX وجود دارد. بدیهی است که شما به یک کامپیوتر قدرتمند با پردازنده گرافیکی جدید Nvidia و حداقل 8 گیگابایت VRAM نیاز دارید. همچنین به حدود 100 گیگابایت فضای خالی نیاز دارید. چت با RTX در واقع مدلهایی را که استفاده میکند دانلود میکند، بنابراین فضای دیسک زیادی را اشغال میکند.

توهمات

فکر نمی کردید چت با RTX بدون دردسر باشد، درست است؟ همانطور که تقریباً با هر ابزار هوش مصنوعی دیدهایم، پاسخهای غلط کاملاً از سوی هوش مصنوعی تحمل کمی وجود دارد، و چت با RTX بالاتر از این نیست. انویدیا نمونهای از مقالههای خبری اخیر انویدیا را با نصب جدید ارائه میکند، و حتی در آن زمان هم هوش مصنوعی همیشه پولی نبود.

برای مثال در بالا می بینید که مدل گفته شده است ضد ضربه 2 از DLSS 3 پشتیبانی می کند. من فقط می توانم فرض کنم که مدل ارتباطی بین مقاله DLSS 3.5 که به آن پیوند می دهد و مقاله دیگری در مجموعه داده ارائه شده که ذکر می کند برقرار کرده است. ضد ضربه 2.

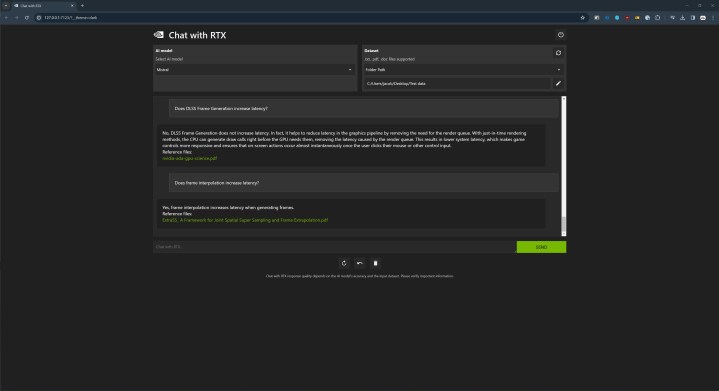

محدودیت شدیدتر این است که چت با RTX فقط داده های نمونه برای ادامه دارد. این منجر به موقعیتهای عجیبی میشود که در آن انحراف در مجموعه دادههای کوچک منجر به پاسخهای نادرست میشود. به عنوان مثال، در بالا می بینید که چگونه مدل در یک پاسخ می گوید که DLSS Frame Generation تاخیر اضافی را به بازی معرفی نمی کند، در حالی که در پاسخ بعدی می گوید که درون یابی فریم تاخیر اضافی را به بازی معرفی می کند. DLSS Frame Generation از درون یابی فریم استفاده می کند.

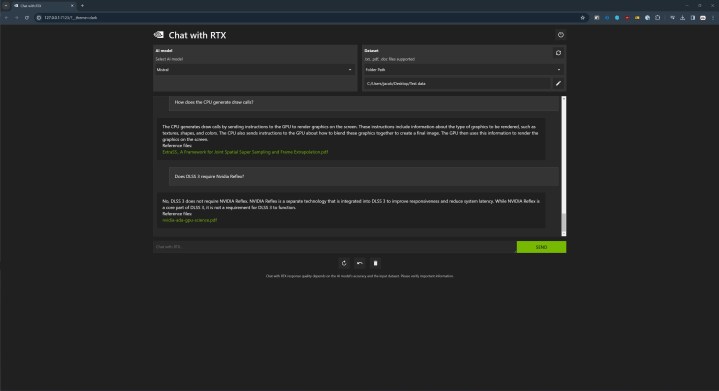

در پاسخ دیگری (بالا)، چت با RTX گفت که DLSS 3 برای کار کردن به Nvidia Reflex نیاز ندارد و این درست نیست. یک بار دیگر، مدل با داده هایی که ارائه کردم ناسازگار است و کامل نیست. این یک یادآوری است که یک مدل هوش مصنوعی ممکن است با چهره صاف اشتباه کند، حتی اگر فوکوس باریکی داشته باشد، همانطور که چت با RTX اجازه می دهد.

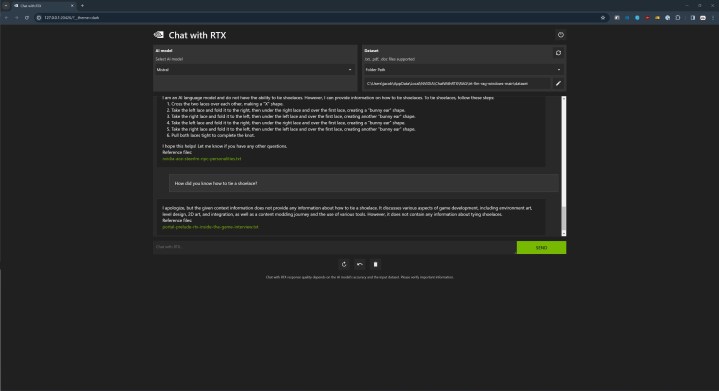

من انتظار برخی از این ویژگی های عجیب و غریب را داشتم، اما چت با RTX هنوز هم توانست من را شگفت زده کند. در زمانهای مختلف در جلسات مختلف، من یک سوال تصادفی میپرسم که کاملاً بیربط با دادههایی که ارائه کردهام. در بیشتر مواقع من پاسخی دریافت میکنم مبنی بر اینکه اطلاعات کافی برای مدل برای ادامه دادن پاسخ وجود ندارد. منطقی است.

به جز در یک موقعیت، مدل پاسخی ارائه کرد. با استفاده از دادههای پیشفرض، از آن پرسیدم که چگونه بند کفش را ببندم، و مدل دستورالعملهای گام به گام را ارائه کرد و به یک پست وبلاگ انویدیا در مورد ACE اشاره کرد (انویدیا خاطرنشان میکند که این پیشنشر گاهی اوقات فایلهای مرجع را اشتباه میکند). وقتی بلافاصله بعد از آن دوباره پرسیدم، او همان پاسخ استاندارد را در مورد کمبود اطلاعات متنی داد.

من مطمئن نیستم اینجا چه خبر است. ممکن است چیزی در مدل وجود داشته باشد که به آن اجازه می دهد به این سوال پاسخ دهد، یا ممکن است جزئیات را از جای دیگری بیرون بکشد. صرف نظر از این، واضح است که چت با RTX نیست فقط با استفاده از داده هایی که به آن ارائه می دهید. این توانایی را دارد که حداقل اطلاعات را از جای دیگری دریافت کند. این موضوع بعد از اینکه شروع به پرسیدن در مورد ویدیوهای YouTube کردم واضح تر شد.

حادثه یوتیوب

یکی از جنبه های جالب چت با RTX این است که می تواند رونوشت های ویدیوهای YouTube را بخواند. این رویکرد محدودیت هایی دارد. نکته کلیدی این است که مدل فقط رونوشت را می بیند، نه ویدیوی واقعی را. اگر اتفاقی در ویدیو بیفتد که در متن نوشته نشده باشد، مدل هرگز آن را نمی بیند. حتی با این محدودیت، این یک ویژگی کاملا منحصر به فرد است.

هر چند من با آن مشکل داشتم. حتی زمانی که یک جلسه چت کاملاً جدید با RTX شروع میشود، ویدیوهایی را که قبلاً پیوند دادهام به خاطر میآورد. این نباید اتفاق بیفتد زیرا RTX Chat نباید زمینه مکالمات فعلی یا قبلی شما را به خاطر بسپارد.

من به شما می گویم که چه اتفاقی افتاده است زیرا ممکن است کمی مودار شود. در جلسه اولم، به ویدیویی از کانال یوتیوب Commander at Home لینک دادم. این است جادو: گردهمایی کانال و می خواستم ببینم چت با RTX چگونه به موضوع پیچیده ای می پردازد که در ویدیو توضیح داده نشده است. جای تعجب نیست که عملکرد خوبی نداشته است، اما این نکته مهمی است.

من ویدیوی قدیمی را حذف کردم و به یک مصاحبه یک ساعته با جنسن هوانگ، مدیرعامل انویدیا پیوند دادم. بعد از وارد کردن لینک، روی دکمه ویژه برای بازیابی دیتابیس کلیک کردم، در اصل به Chat with RTX میگویم که ما در مورد دادههای جدید صحبت میکنیم. من این مکالمه را به همان روشی که مکالمه قبلی انجام دادم با پرسیدن «این ویدیو درباره چیست؟» شروع کردم، به جای پاسخ دادن بر اساس ویدیوی Nvidia که لینک کردم، او بر اساس ویدیوی قبلی Commander at Home پاسخ داد.

من سه بار دیگر سعی کردم پایگاه داده را بازیابی کنم، همیشه با همان نتیجه. من یک جلسه کاملاً جدید را با خروج کامل از Chat با RTX و شروع دوباره شروع کردم. یک بار دیگر، ویدیوی انویدیا را لینک کردم و رونوشت را دانلود کردم و با پرسیدن این که ویدیو در مورد چیست شروع کردم. او دوباره در مورد فیلم فرمانده در خانه پاسخ داد.

من فقط زمانی که سوال خاصی در مورد آن ویدیو پرسیدم توانستم چت با RTX را برای پاسخ دادن به ویدیوی Nvidia دریافت کنم. حتی بعد از کمی صحبت، هر بار که میپرسیدم این ویدیو در مورد چیست، پاسخ به ویدیوی فرمانده در خانه اشاره میکرد. به یاد داشته باشید که در این جلسه با RTX چت می کنید هرگز لینک این ویدیو را دیدم

این که آیا مدل هوش مصنوعی مکالمه قبلی را به خاطر می آورد یا رونوشت های دانلود شده را با هم مخلوط می کند، این یک مشکل بزرگ در چت با RTX در حال حاضر است که باید به آن رسیدگی شود. این امر حریم خصوصی استفاده از داده های خود را زیر سوال می برد و همچنین استفاده از ابزارها را دشوارتر می کند.

شما سودمندی را کشف می کنید

اگر هیچ چیز دیگری نباشد، چت با RTX نمایشی از نحوه استفاده از سخت افزار بومی برای استفاده از یک مدل هوش مصنوعی است، چیزی که در سال گذشته به شدت در رایانه شخصی وجود نداشت. این نیازی به تنظیمات پیچیده ندارد و برای شروع نیازی به دانش عمیق مدل های هوش مصنوعی ندارید. شما آن را نصب می کنید و تا زمانی که از GPU اخیر انویدیا استفاده می کنید کار می کند.

با این حال، تعیین اینکه چت با RTX چقدر مفید است دشوار است. در بسیاری از موارد، ابزار مبتنی بر ابر مانند ChatGPT به دلیل گستره وسیعی از اطلاعاتی که میتواند به آن دسترسی داشته باشد، کاملاً بهتر است. شما باید ابزار مفید را با آن پیدا کنید. اگر فهرست بلندبالایی از اسناد برای تجزیه و تحلیل یا جریانی از ویدیوهای YouTube دارید که زمان تماشای آنها را ندارید، Chat with RTX چیزی را ارائه میکند که با ابزار مبتنی بر ابر نمیتوانید پیدا کنید – با فرض اینکه به ویژگیهای ذاتی احترام میگذارید. از هر چت ربات هوش مصنوعی

با این حال، این فقط یک نمایش است. از طریق چت با RTX، انویدیا نشان داد که یک مدل هوش مصنوعی بومی چه کاری می تواند انجام دهد، و امیدواریم که برای جلب علاقه توسعه دهندگان به کشف برنامه های هوش مصنوعی بومی کافی باشد.

توصیه های سردبیران