خیر، ChatGPT باعث کمبود جدید GPU نمی شود

ChatGPT در حال انفجار است و ستون فقرات مدل هوش مصنوعی آن به کارت های گرافیک Nvidia متکی است. یکی از تحلیلگران گفت که حدود 10000 پردازنده گرافیکی Nvidia برای آموزش ChatGPT استفاده شده است، و با ادامه گسترش این سرویس، نیاز به GPU نیز افزایش می یابد. هر کسی که در رونق کریپتو در سال 2021 زندگی کرده باشد، می تواند احساس کمبود GPU را در افق حس کند.

من چندین خبرنگار را دیده ام که دقیقاً این ارتباط را برقرار کرده اند، اما اشتباه است. روزهای کمبود پردازنده های گرافیکی با مدیریت رمزارز پشت سر ماست. در حالی که احتمالاً با ادامه رشد هوش مصنوعی شاهد افزایش تقاضا برای کارتهای گرافیک خواهیم بود، این تقاضا متوجه بهترین کارتهای گرافیکی نصب شده در سیستمهای بازی نیست.

چرا GPU های Nvidia برای هوش مصنوعی ساخته شده اند؟

ابتدا به این خواهیم پرداخت که چرا کارت های گرافیک انویدیا برای هوش مصنوعی بسیار خوب هستند. انویدیا در چند سال گذشته روی هوش مصنوعی شرط بندی کرده است و با افزایش قیمت سهام این شرکت پس از افزایش ChatGPT نتیجه داده است. دو دلیل وجود دارد که چرا Nvidia را در قلب آموزش هوش مصنوعی می بینید: هسته های تانسور و CUDA.

CUDA رابط برنامه نویسی کاربردی انویدیا (API) است که در همه چیز از گران ترین پردازنده های گرافیکی برای مراکز داده تا ارزان ترین پردازنده های گرافیکی برای بازی استفاده می شود. شتاب CUDA در کتابخانههای یادگیری ماشینی مانند TensorFlow پشتیبانی میشود و سرعت آموزش و استنتاج را بسیار افزایش میدهد. CUDA نیروی محرکه ای است که AMD در هوش مصنوعی در مقایسه با Nvidia بسیار عقب است.

با این حال، CUDA را با هسته های CUDA انویدیا اشتباه نگیرید. CUDA پلتفرمی است که بسیاری از برنامههای هوش مصنوعی روی آن اجرا میشوند، در حالی که هستههای CUDA فقط هستههای پردازندههای گرافیکی Nvidia هستند. آنها یک نام مشترک دارند و هسته های CUDA برای اجرای برنامه های CUDA بهتر بهینه شده اند. پردازندههای گرافیکی بازی Nvidia دارای هستههای CUDA هستند و از برنامههای CUDA پشتیبانی میکنند.

هسته های تانسور اساساً هسته های تخصصی هوش مصنوعی هستند. آنها ضرب ماتریس را کنترل می کنند، که سس مخفی است که یادگیری هوش مصنوعی را سرعت می بخشد. ایده در اینجا ساده است. چندین مجموعه داده را به طور همزمان ضرب کنید و با تولید نتایج احتمالی، مدل های هوش مصنوعی را به صورت تصاعدی سریعتر آموزش دهید. اکثر CPU ها وظایف را به صورت خطی انجام می دهند، در حالی که هسته های Tensor می توانند به سرعت اسکریپت ها را در یک ساعت تولید کنند.

باز هم، پردازندههای گرافیکی بازی انویدیا مانند RTX 4080 هستههای Tensor دارند (و گاهی حتی بیشتر از پردازندههای گرافیکی گرانقیمت مرکز داده). با این حال، برای تمام مشخصات، کارتهای انویدیا باید مدلهای هوش مصنوعی را تسریع کنند، که هیچ کدام به اندازه حافظه مهم نیستند. و پردازنده های گرافیکی بازی انویدیا حافظه زیادی ندارند.

همه چیز به حافظه برمی گردد

به گفته جفری هیتون، نویسنده چندین کتاب در زمینه هوش مصنوعی و استاد دانشگاه واشنگتن در سنت لوئیس، «اندازه حافظه بیشترین اهمیت را دارد». اگر رم GPU کافی ندارید، مدل تناسب/استنتاج شما متوقف می شود.

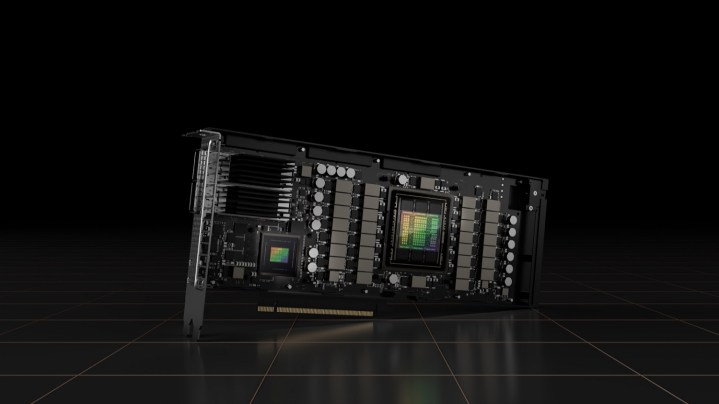

هیتون که یک کانال یوتیوب دارد که به عملکرد خوب مدلهای هوش مصنوعی در پردازندههای گرافیکی خاص اختصاص دارد، خاطرنشان کرد که هستههای CUDA نیز مهم هستند، اما ظرفیت حافظه عامل غالب در مورد نحوه عملکرد پردازندههای گرافیکی برای هوش مصنوعی است. RTX 4090 بر اساس استانداردهای بازی دارای حافظه زیادی است – 24 گیگابایت GDDR6X – اما در مقایسه با پردازندههای گرافیکی درجه مرکز داده بسیار کم است. به عنوان مثال، آخرین GPU H100 Nvidia دارای 80 گیگابایت حافظه HBM3 و همچنین یک گذرگاه حافظه عظیم 5120 بیتی است.

شما می توانید با کمتری از پس آن بر بیایید، اما همچنان به حافظه زیادی نیاز دارید. هیتون توصیه می کند مبتدیان کمتر از 12 گیگابایت حافظه ندارند، در حالی که مهندسان یادگیری ماشین معمولی یک یا دو پردازنده گرافیکی حرفه ای انویدیا با ظرفیت 48 گیگابایت خواهند داشت. به گفته Heaton، “بیشتر حجم کاری در محدوده A100 تا هشت A100 بیشتر خواهد بود.” GPU A100 Nvidia دارای 40 گیگابایت حافظه است.

شما همچنین می توانید این مقیاس بندی را در عمل مشاهده کنید. Puget Systems یک A100 تکی با 40 گیگابایت حافظه را نشان میدهد که تقریباً دو برابر سریعتر از یک RTX 3090 با حافظه 24 گیگابایتی کار میکند. و این در حالی است که RTX 3090 تقریباً دو برابر تعداد هسته های CUDA و تقریباً تعداد هسته های Tensor دارد.

حافظه گلوگاه است، نه قدرت پردازش خام. این به این دلیل است که آموزش مدلهای هوش مصنوعی به مجموعههای بزرگی از دادهها متکی است و هر چه تعداد بیشتری از این دادهها را در حافظه ذخیره کنید، سریعتر (و دقیقتر) میتوانید یک مدل را آموزش دهید.

نیازهای مختلف، مرگهای متفاوت

پردازندههای گرافیکی بازی انویدیا به دلیل حافظه کمی که نسبت به سختافزار کلاس سازمانی دارند، معمولاً برای هوش مصنوعی مناسب نیستند، اما در اینجا نیز یک مشکل جداگانه وجود دارد. پردازندههای گرافیکی ایستگاه کاری انویدیا معمولاً یک پردازنده گرافیکی را با کارتهای بازی خود به اشتراک نمیگذارند.

به عنوان مثال، A100 که Heaton به آن اشاره کرد از یک پردازنده گرافیکی GA100 استفاده می کند که یک قالب از طیف Ampere انویدیا است که هرگز در کارت های متمرکز بر بازی (از جمله RTX 3090 Ti رده بالا) استفاده نشده است. به همین ترتیب، آخرین H100 انویدیا از معماری کاملاً متفاوتی با سری RTX 40 استفاده می کند، به این معنی که از ماتریس متفاوتی نیز استفاده می کند.

استثناهایی هم وجود دارد. پردازنده گرافیکی AD102 انویدیا، که در RTX 4090 و RTX 4080 قرار دارد، همچنین در طیف کوچکی از پردازندههای گرافیکی سازمانی Ada Lovelace (L40 و RTX 6000) استفاده میشود. با این حال، در بیشتر موارد، انویدیا نمیتواند فقط پردازنده گرافیکی بازی را برای یک کارت مرکز داده تغییر کاربری دهد. آنها جهان های جداگانه ای هستند.

برخی تفاوتهای اساسی بین کمبود GPU وجود دارد که به دلیل استخراج کریپتو و افزایش محبوبیت مدلهای هوش مصنوعی دیدهایم. به گفته Heaton، مدل GPT-3 به بیش از 1000 پردازنده گرافیکی A100 Nvidia برای آموزش و حدود هشت پردازنده برای کارکرد نیاز دارد. این پردازندههای گرافیکی همچنین به اتصال پرسرعت NVLink دسترسی دارند، در حالی که پردازندههای گرافیکی سری RTX 40 انویدیا این امکان را ندارند. حداکثر 24 گیگابایت حافظه کارت های بازی انویدیا را با چند صد پردازنده گرافیکی مانند A100 با NVLink مقایسه می کند.

نگرانیهای دیگری نیز وجود دارد، مانند ذخیره حافظهها برای پردازندههای گرافیکی حرفهای بهجای پردازندههای بازی، اما روزهای عجلهای که برای یافتن یک GPU موجود در انبار به مرکز Micro یا Best Buy محلیتان میرفتید گذشته است. Heaton این نکته را به خوبی خلاصه کرد: «مدلهای زبان بزرگ مانند ChatGPT برآورد شده است که برای اجرا به حداقل هشت GPU نیاز دارند. چنین رتبهبندیهایی شامل پردازندههای گرافیکی سطح بالا A100 میشوند. حدس من این است که این ممکن است باعث کمبود پردازندههای گرافیکی رده بالا شود، اما ممکن است روی پردازندههای گرافیکی درجه یک گیمر با رم کمتر تأثیری نداشته باشد.

توصیه های سردبیران